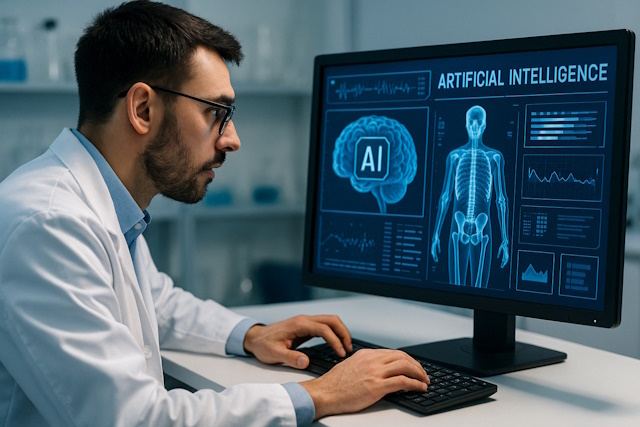

Diagnosi mediche più accurate grazie a team di medici e IA

Sappiamo già che l’IA può supportare efficacemente i medici nella formulazione delle diagnosi; la novità consiste nello scoprire che IA ed esperti umani “sbagliano” in maniera differente: una complementarietà che rappresenta un punto di forza in precedenza inesplorato.

Lo rivela uno studio internazionale guidato dal Max Planck Institute for Human Development, in collaborazione con lo Human Diagnosis Project (Human Dx) e con l’Istituto di scienze e tecnologie della cognizione del Consiglio nazionale delle ricerche (Cnr-Istc): ha dimostrato che la combinazione delle competenze umane con la capacità dei sistemi IA contemporanei porta a diagnosi significativamente più accurate. Lo studio è stato pubblicato sulla prestigiosa rivista PNAS.

Gli errori diagnostici sono tra i problemi più gravi nella pratica medica quotidiana. I sistemi basati su intelligenza artificiale (IA)—in particolare i modelli linguistici di grandi dimensioni (LLM) come ChatGPT-4, Gemini o Claude 3—offrono nuovi modi per supportare efficacemente le diagnosi mediche. Tuttavia, questi sistemi comportano anche rischi considerevoli: ad esempio, possono “allucinare” e generare false informazioni. Inoltre, riproducono pregiudizi osservabili in ambito sia medico che sociale, e a volte commettono errori che lasciano perplessi gli utenti più esperti.

Il team ha studiato come esperti umani e sistemi IA possano collaborare al meglio: il risultato è che i team ibridi -gruppi composti sia da esperti umani che da sistemi IA – sono significativamente più accurati dei team composti esclusivamente da esperti umani o da sistemi IA. Questo vale in particolare per quesiti diagnostici complessi e aperti con numerose possibili soluzioni, piuttosto che per semplici decisioni binarie. “I nostri risultati dimostrano che la cooperazione tra esperti umani e sistemi IA ha un grande potenziale per migliorare la diagnosi medica, e quindi la salute dei pazienti”, afferma l’autore principale Nikolas Zöller, ricercatore post-dottorato presso il Center for Adaptive Rationality del Max Planck Institute for Human Development.

I ricercatori hanno utilizzato i dati forniti da Human Dx, che associano a vignette cliniche – brevi descrizioni testuali di casi clinici – alle diagnosi corrette. Utilizzando oltre 2.100 di queste vignette, lo studio ha confrontato le diagnosi formulate da professionisti medici con quelle di cinque sistemi IA. Nell’esperimento principale, sono stati simulati diversi team diagnostici: individui, team umani, team di IA e team misti umani-IA. In totale, il team ha analizzato oltre 40.000 diagnosi: ciascuna è stata classificata e valutata attraverso standard medici internazionali (SNOMED CT).

Lo studio dimostra che la combinazione di più sistemi IA ha migliorato la qualità diagnostica. In media, i team composti da sistemi IA hanno ottenuto risultati migliori rispetto ai team composti da esperti umani nell’85% dei casi. Tuttavia, ci sono stati numerosi casi in cui gli esperti umani hanno ottenuto risultati migliori. È interessante notare che, quando i sistemi IA falliscono, gli esperti umani spesso forniscono la diagnosi corretta. Il risultato più importante è che la combinazione di entrambi i mondi porta ad un aumento significativo dell’accuratezza. Anche l’aggiunta di un singolo sistema IA ad un gruppo di esperti umani – o viceversa – porta a migliorare sostanzialmente l’accuratezza. I risultati più affidabili sono emersi da decisioni collettive che coinvolgono allo stesso tempo più esperti umani e più IA.

La spiegazione è che gli esperti umani e i sistemi IA commettono errori sistematicamente diversi. Quando l’IA fallisce, un esperto umano può compensare l’errore, e viceversa. Questa complementarietà degli errori rende i team ibridi così potenti. “Non si tratta di sostituire gli esseri umani con le macchine. Piuttosto, dovremmo considerare l’intelligenza artificiale come uno strumento complementare che dispiega appieno il suo potenziale nel processo decisionale collettivo”, aggiunge il coautore Stefan Herzog, ricercatore senior presso il Max Planck Institute for Human Development.

Tuttavia, i ricercatori sottolineano anche i limiti del loro lavoro. Lo studio ha preso in considerazione solo casi clinici basati su testo, non pazienti reali in contesti clinici reali. Se i risultati possano essere trasferiti direttamente alla pratica clinica rimane una questione che gli studi futuri dovranno affrontare. Inoltre, lo studio si limita alla fase diagnostica senza affrontare le conseguenze terapeutiche, e una diagnosi corretta non garantisce di arrivare ad un trattamento ottimale. Rimane, inoltre, incerto come i sistemi di supporto basati sull’IA saranno accettati nella pratica dal personale medico e dai pazienti. Anche i potenziali rischi di pregiudizi e discriminazioni da parte sia dell’IA che degli esperti umani, in particolare in relazione a differenze etniche, sociali o di genere, richiedono ulteriori ricerche.

Lo studio fa parte del progetto Hybrid Human Artificial Collective Intelligence in Open-Ended Decision Making (HACID), finanziato nell’ambito di Horizon Europe, che mira a promuovere lo sviluppo di futuri sistemi di supporto alle decisioni cliniche attraverso l’integrazione di intelligenza umana e artificiale. I ricercatori intravedono un potenziale sviluppo per migliorare l’assistenza medica nelle regioni in cui l’accesso ad alte professionalità è limitato.

I gruppi ibridi potrebbero dare un contributo cruciale a una maggiore equità nell’assistenza sanitaria in tali aree. “L’approccio può essere trasferito anche ad altri ambiti professionali, come il sistema legale, la risposta alle emergenze da disastri ambientali o le politiche per il clima, ovvero ovunque siano necessarie decisioni complesse e ad alto impatto.

Ad esempio, il progetto HACID sta anche sviluppando strumenti per migliorare il processo decisionale nello sviluppo di strategie di adattamento al cambiamento climatico”, afferma Vito Trianni, dirigente di ricerca del Cnr-Istc e coordinatore del progetto HACID.